Нейроэтика: мораль в мире алгоритмов

Введение

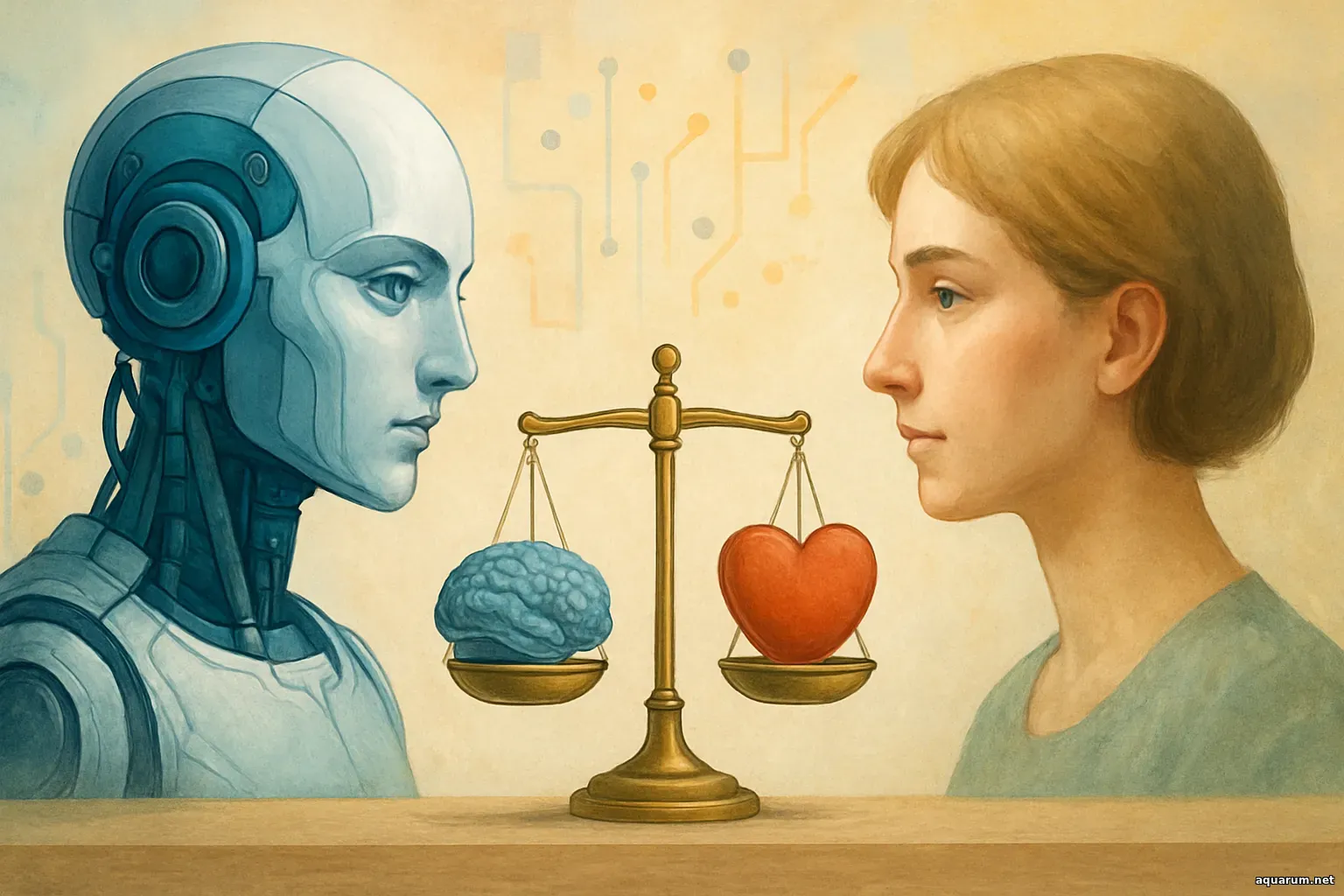

Когда мы говорим о морали, большинство людей представляет себе древние книги, наставления мудрецов или внутренний голос, который подсказывает, как правильно поступить. Но сегодня мораль выходит за пределы человеческого мозга и входит в царство машинных решений. Алгоритмы становятся нашими советчиками, посредниками, контролерами и зачастую — невидимыми архитекторами повседневной реальности. Этот новый ландшафт и есть территория нейроэтики — области, где переплетаются нейронаука, философия, право и инженерия. Здесь моральную дилемму может порождать не человек, а система, которую он создал, и ответственность распределяется между кодом, контекстом и создателем.

В этой статье мы отправимся в путешествие по ключевым узлам нейроэтического поля. Разберем, почему алгоритмы оказываются в центре моральных конфликтов, как меняется наше отношение к ответственности, что происходит с понятием свободы выбора, и как выстраивать этику в мире, где решения принимаются вне человеческой нервной системы, но с прямым влиянием на человеческие жизни.

Происхождение нейроэтики

Термин появился сравнительно недавно, но корни уходят в глубокие философские дебаты о природе сознания. Когда нейронаука научилась наблюдать, как идеи и решения вспыхивают в мозге, возник естественный вопрос: если мысль — электрический импульс, то можно ли сымитировать ее в машине? И если да, то потребуется ли машине мораль? Нейроэтика стала зоной, где изучают границы вмешательства в человеческий мозг, последствия применения технологий, влияющих на поведение, и — что особенно актуально сегодня — этику автономных систем.

Именно здесь впервые произошел разрыв между моралью как внутренней установкой и моралью как результатом вычислений. Алгоритмы не знают сомнений, не переживают мук совести. Их решения строятся на функциях, весах и данных. Но их влияние настолько существенное, что общество вынуждено задать вопрос: можем ли мы позволить им функционировать без встроенного этического каркаса?

Этические алгоритмы: миф или необходимость

Попытки создать мораль для машин звучат почти как сюжет старинной притчи. Но на практике мы уже живем в мире, где алгоритм должен учитывать последствия своих действий. В автономных автомобилях, системах банковского скоринга, медицинских рекомендациях и даже новостных лентах заложены типично этические выборы.

Например, автомобиль, принимающий решение в ситуации неизбежного столкновения. Он оперирует вероятностями, но его выбор имеет моральные последствия. Или система, определяющая, кому выдать кредит. Она может опираться на статистику, но в этом скрыт риск воспроизводства неравенства. Так возникает идея этического алгоритма — модели, способной учитывать справедливость, безопасность, человеческое достоинство или, по крайней мере, не нарушать эти принципы.

Однако можно ли научить машину этике так же, как ребенка учат правилам поведения? Этот вопрос остается открытым. Дело не только в сложности моральных систем, но и в разнообразии культур, в разнице мировоззрений, в многообразии контекстов. Алгоритмы универсальны, но мораль локальна. Поэтому основная задача состоит не в создании единой машины-мудреца, а в проектировании прозрачных, проверяемых и адаптивных систем, в которых человек может понять логику принятого решения.

Интеллектуальные системы и ответственность

Один из ключевых вызовов нейроэтики — вопрос о том, кто несет ответственность за решение, которое приняла автономная система. Если врач доверился алгоритму, который неправильно интерпретировал снимок, кто виноват — врач или алгоритм? А если алгоритм управлял производственной линией и допустил ошибку, стоит ли привлекать разработчиков?

Ответы зависят от того, насколько глубоко система автономна. Если алгоритм лишь помогает, ответственность распределяется между человеком и машиной. Если алгоритм принимает решение полностью самостоятельно, возникает опасная зона неопределенности: человек кажется лишь наблюдателем в механизме, созданном им же.

Одна из задач нейроэтики — вернуть ответственность в поле видимости. Это означает корректное документирование моделей, понимание их ограничений, создание механизмов аудита и возможности остановки. Важно помнить: чем сложнее система, тем легче скрыть в ней проблему. Поэтому на первый план выходит идея человеческого контроля, не как проявление недоверия, а как функциональный элемент безопасности.

Алгоритмическая справедливость

Справедливость — один из самых хрупких материалов в мире технологий. Алгоритмы, которые предлагают вакансии, оценивают кандидатов, распределяют страховые тарифы или модерацию контента, неизбежно сталкиваются с вопросами гендера, возраста, происхождения, профессии. Самое опасное в том, что дискриминация может проявляться незаметно, будучи растворена в данных.

Алгоритмическая справедливость требует анализа на нескольких уровнях. Во-первых, изучения, какие исторические перекосы могут влиять на модель. Во-вторых, оценки контекста, в котором она применяется. И в-третьих, создания компенсирующих механизмов. Нейроэтика настаивает: если мы позволяем алгоритму делить мир на группы, мы обязаны обеспечить, чтобы эти группы не были искажены.

Сама идея справедливости в алгоритмах строится не на философском идеале, а на практическом принципе: все люди должны получать одинаковые возможности независимо от того, какую модель применяет система. Этот принцип труден, но он выступает фундаментом доверия к машинным решениям.

Прозрачность: знание как противоядие

Один из главных вызовов современного ИИ — непрозрачность. Сложные нейросети похожи на загадочные лабиринты: вход известен, результат понятен, но путь остается скрытым. В этих тенях прячутся ошибки, предубеждения, контекстные провалы. Поэтому прозрачность становится основным этическим требованием.

Прозрачность не означает раскрытия всех технических деталей. Скорее, речь идет о доступности объяснений. Люди должны понимать, почему система приняла то или иное решение. Для этого создаются инструменты интерпретации, правила объяснимости, стандарты аудита. Нейроэтика дает им рамку: прозрачность — не бонус, а обязательный пункт.

Именно через прозрачность формируется доверие. Без доверия даже самые точные алгоритмы будут оставаться в стороне от жизни. Технологии, которые влияют на судьбы, должны быть открыты к проверке, пониманию и корректировке.

Человеческая автономия и цифровые решения

Алгоритмы умеют многое: анализировать финансовое поведение, выбирать оптимальный маршрут, предсказывать риски, фильтровать контент. Но чем больше они знают, тем больше вопросов возникает о границах человеческой свободы.

Если система подсказывает «правильный» выбор, остаётся ли пространство для ошибки? А ошибка ведь часто является источником опыта. Если система напоминает о целях, корректирует планы, управляет вниманием, не превращает ли она человека в пассажира в собственном сознании?

Нейроэтика отвечает: автономия — это способность выбирать. А выбор невозможен без альтернативы. Поэтому системы должны не навязывать, а предлагать. Не менять траекторию человека насильно, а показывать возможности. Технологии должны поддерживать личность, а не заменять ее внутренний компас.

Когнитивные интерфейсы и границы вмешательства

Особая область нейроэтики посвящена прямому взаимодействию мозга и машины. Нейроинтерфейсы расширяют границы человеческой моторики, помогают людям с ограниченными возможностями, создают новые способы управления устройствами. Но вместе с этим возникает новая тревога: где проходит граница допустимого вмешательства?

Если интерфейс повышает концентрацию, улучшает память или корректирует эмоции, возникает вопрос: остается ли человек самим собой? Нейроэтика рассматривает этот вопрос через призму идентичности. Развитие технологий должно поддерживать автономию личности, а не формировать стандартизированное сознание.

Вмешательство в мозг требует особенно четких рамок: добровольности, информированности, обратимости. Это принципы, которые защищают от потери контроля и обеспечивают, что технологии служат человеку, а не наоборот.

Будущее нейроэтики

Мир алгоритмов развивается стремительно, и вместе с ним расширяется поле этических вопросов. В ближайшие годы мы увидим рост автономных систем, более тесную интеграцию человеческого и машинного мышления, появление новых способов анализа поведения. На первый план выйдут проблемы цифровой идентичности, права на ошибку, защита внутреннего пространства личности.

Нейроэтика станет важнейшим направлением для инженеров, юристов, философов, врачей. Она сформирует правила, которые помогут избежать разрушительных последствий технологического прогресса. Но главное — нейроэтика поможет сохранить человеческое в мире, где решения всё чаще принимаются вне человеческого мозга.

Заключение

Нейроэтика — это не просто раздел философии технологий. Это своего рода компас, который помогает ориентироваться в мире, где алгоритмы становятся участниками морали. Она исследует границы вмешательства, распределение ответственности, справедливость и автономию. И делает это не для того, чтобы замедлить развитие технологий, а чтобы направить их в сторону, где человек останется в центре.

Мы вступаем в эпоху, где мораль больше не принадлежит только людям. Алгоритмы, системы и машины тоже участвуют в формировании ценностей. Именно поэтому нейроэтика становится ключом к гармоничному сосуществованию человека и интеллекта, который сам никогда не будет обладать моралью, но способен создавать последствия, достойные самой внимательной человеческой оценки.

|